A FGV promoveu um debate sobre ética e governança da Inteligência Artificial em organizações. Na sexta-feira, a Consumidor Moderno acompanhou a discussão sobre a criação de Comitês de Ética em IA nas empresas, principalmente em grandes companhias. O Centro de Ensino e Pesquisa em Inovação (CEPI) da FGV Direito SP aproveitou a ocasião para lançar uma pesquisa inédita, que provavelmente terá repercussão internacional, falando sobre o tema.

Os pesquisadores da FGV destacaram que ao pensarmos em uma Inteligência Artificial responsável, as soluções não são nada óbvias e para além de refletirmos sobre regulamentação, é essencial discutir a governança dentro das organizações e os processos de tomada de decisões. Segundo eles, é necessário olhar para as características das empresas, os riscos que as soluções propostas representam para a sociedade e entender que os impactos da IA ultrapassam as questões técnicas e tecnológicas.

Durante o debate foi enfatizado, por exemplo, que cada empresa deverá ter uma carta de princípios para a utilização da IA e que esses valores precisam ser trabalhados e incorporados por todos os times, não apenas por equipes de TI. Através desses princípios organizacionais, as empresas conseguirão construir ambientes éticos, com diretrizes palpáveis e normas que, de fato, funcionem.

Os Comitês de Ética em IA são importantes nesse sentido, pois eles ajudam a sistematizar os caminhos dentro do contexto de cada organização. Eles cumprem o papel de ser um ambiente de discussão em que um grupo de pessoas, de vários setores, se reúnem para organizar e orientar as estruturas éticas da empresa, para tornar possível soluções de IA responsáveis (capazes de tomar decisões importantes nas vidas das pessoas); explicáveis; e auditáveis.

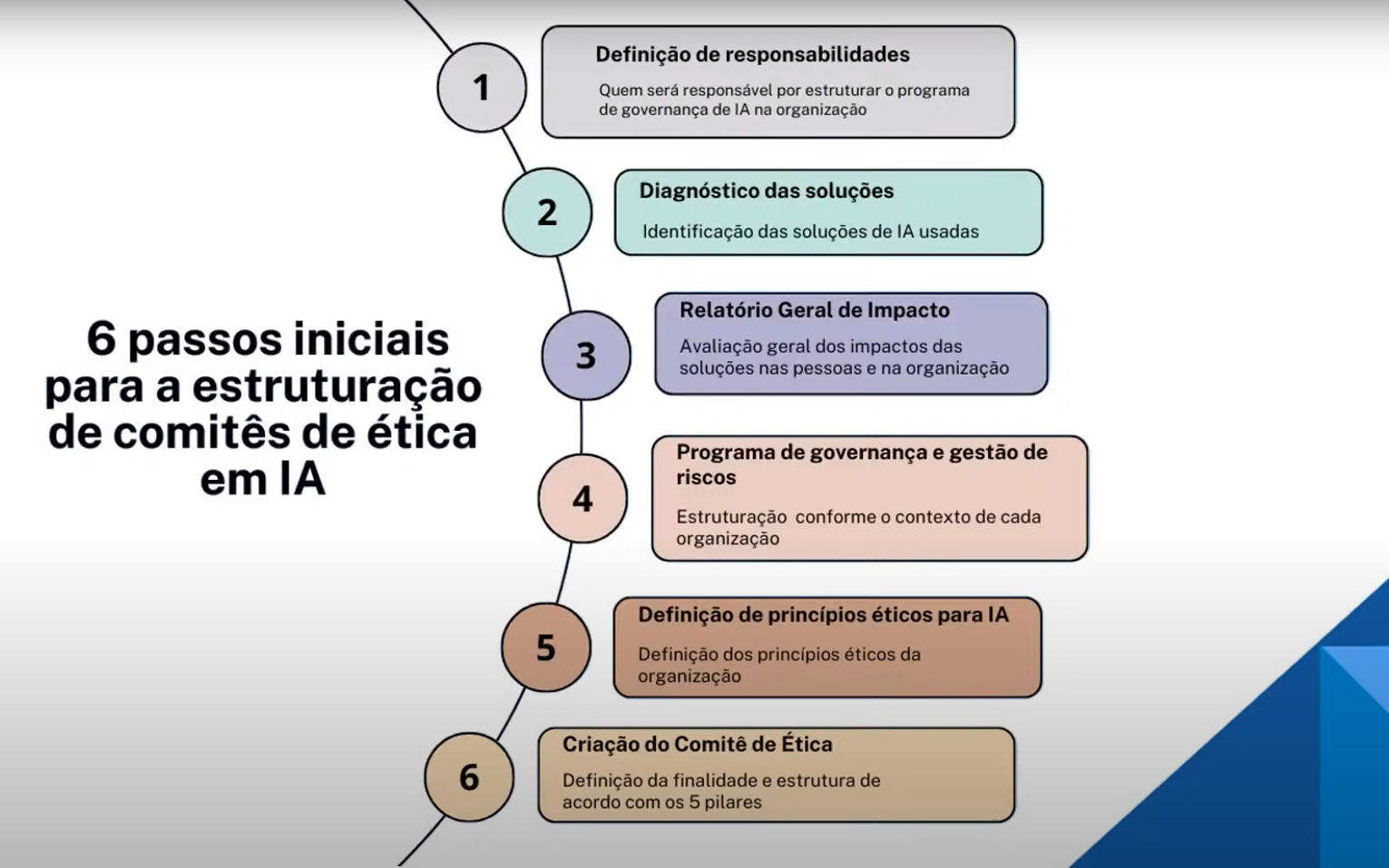

Um programa de governança e prevenção de risco para ser bem sucedido, deve passar pelas seguintes etapas: definição do problema; documentação; impacto de risco; análise de saídas; e constituição de um Comitê de Ética. Atualmente, segundo o levantamento feito pelo CEPI-FGV existem apenas 23 Comitês do tipo no mundo. A maioria foi criada entre 2016 e 2020.

Para os pesquisadores isso mostra como a discussão de IA responsável e das estruturas necessárias para que as soluções de fato sejam enquadradas em conceitos éticos, ainda é muito embrionária. Isso, tanto no mundo corporativo, quanto na academia e na literatura. Em 2016, os Comitês de Ética em Ia criados eram em sua maioria externos às empresas. Na prática, eram formados por consultores independentes que faziam observações e aconselhamentos às lideranças. A única exceção era o da Microsoft, que era composto por membros da própria companhia, de áreas diversas.

Dos primeiros Comitês a serem criados, os pesquisadores também destacaram o da Axom, que com menos de cinco anos de existência, já lançou dois relatórios públicos detalhados sobre a remuneração dos membros, processo decisório e produtos revisados. Entre 2020 e 2022, de acordo com a pesquisa, foram criados sete Comitês de Ética em IA. Desses, vale a pena destacar o da Orange, o da Embrapii e o da Panasonic.

Esses dois últimos têm uma característica diferente: são formados por mais de uma empresa e trazem a ideia de governança em rede. O da Embrapii é um Comitê de Rede, formado por várias instituições. O da Panasonic, que começou a ser discutido em 2019 e foi operacionalizado em 2022, traz uma estrutura de holding. Ou seja, há uma variedade de maneiras de estruturação desses Comitês de Ética, que devem ser pensados e estruturados norteados pelos princípios e características de cada organização.

Como montar um Comitê de Ética em IA?

A pesquisa da FGV elaborou um framework com os cinco pilares para montar o Comitê de Ética da sua empresa e a aplicação deles passo a passo. Eles têm como base, os princípios do Fórum Econômico Mundial e de organizações como a Unesco, o Conselho Europeu e o OCDE. Os pilares são:

- Finalidade

- Estrutura

- Composição

- Poder

- Processo Decisório

A finalidade, por exemplo, vai variar de acordo com as características da empresa e da solução de IA a ser implementada. Lembrando do Conselho de Medicina, que é muito tradicional na sociedade brasileira, a finalidade pode ser desde orientativa, informativa, até normativa e repressiva. Em relação à composição, como já falamos, o Comitê pode ser formado de pessoas de dentro ou de fora da empresa, tudo vai depender do que faz sentido em cada situação.

Segundo os pesquisadores para que o Comitê de Ética em Ia das empresas funcione de fato e se consolide neste papel de garantir o uso da IA em soluções de forma responsável, é essencial que haja uma definição de responsabilidades; um diagnóstico das soluções, porque muitas vezes o que chamam de IA não é de fato IA; um relatório geral de impacto, que vai definir as estruturas necessárias com base nos riscos.

Especialistas destacaram ainda a importância de entender que tecnologia e ética permeiam a todos no universo das empresas: grandes corporações, médias, pequenas e até os empreendedores que trabalham na informalidade. Quando falamos em Comitê de Ética, estamos falando de um recorte, um extrato desse bolo. Eles lembraram que no dia a dia, a tecnologia vem na frente dos conceitos de ética e responsabilidade, essa reflexão até existe, mas só ganha mais evidência depois de três ou cinco anos que a solução está no mercado.

É importante enfatizar ainda que não basta criar o Comitê de Ética em IA, é importante que ele funcione. Também é relevante, de acordo com os especialistas, deixar clara a definição de IA, evitando dar margem para “maquiagem” e enfatizar quando se fala sobre ética, os riscos associados ao uso da IA, porque isso “soa melhor aos ouvidos dos empresários”.

Como o conceito de IA Responsável vem sendo trabalhado pelas gigantes

Diego Canabarro, head de Política de Privacidade da Meta no Brasil, afirma que não existe uma fórmula única, ou uma resposta unânime quando o assunto é IA responsável. Segundo ele, a Meta reconhece que estamos em um momento de experimentar e de tentar achar as alternativas possíveis para fazer governança de IA em múltiplas dimensões e múltiplas frentes. “Não há um pré modelo definido próprio capaz de dar conta da complexidade desse tema”, explica.

O executivo conta que a Meta está atuando em duas frentes nesse sentido: uma interna, que é basicamente a maneira como a empresa atua no chão de fábrica; e a externa, que é a forma com que a Meta se relaciona com os outros atores do ecossistema. Internamente, de acordo com Diego, a Meta adotou um conjunto de pilares fundamentais para o uso da Inteligência Artificial de forma responsável.

“A gente adotou a declaração de princípios para orientar todo o desenvolvimento da alocação de responsabilidade da distribuição dos diferentes times. E esses pilares têm a ver com aqueles cinco princípios que já estão meio que convencionados que são: Transparência e Controle; Privacidade e segurança; governança em uma perspectiva ampla; Robustez e Segurança; e Equidade e Justiça”, relata o head de Política de Privacidade da Meta no Brasil.

A ideia, segundo ele, é incrementar a forma com que a organização se relaciona com os usuários e a criação de ferramentas para que os usuários exerçam um controle maior sobre a experiência deles dentro dos serviços da plataforma. “No meio do ano passado, a empresa entendeu que responsabilidade não pode ser um tema para uma única estrutura dentro da organização por conta da escala em que a gente opera. IA responsável tem que ser uma coisa embedada no funcionamento de toda a estrutura e nos diversos times”, afirma Diego.

Externamente, Diego explica que a Meta tem trabalhado em múltiplas frentes de colaboração. Eles participam, por exemplo, do grupo de negócios da OCDE, onde empresas têm sido convidadas para documentar os dilemas que têm enfrentado no uso de inteligência artificial. Outro caminho encontrado pela Meta, tem sido trabalhar com instituições de ensino e pesquisa, como a universidade de San Andrés, na Argentina, que tem mapeado as características que devem ser levadas em conta na discussão da IA responsável na América Latina, como o contexto socioeconômico, a demografia e o estágio de desenvolvimento da tecnologia em cada lugar.

Já Loren Spíndola, do grupo de políticas públicas da Microsoft, analisa que a empresa já entendeu que de nada adianta ter princípios bem definidos se não houver governança, pois é isso que garante que os princípios sejam entendidos por todos. Loren conta que a Microsoft já conta com uma série de estruturas em função de analisar riscos e criar soluções de IA responsáveis. Uma delas é composta por cientistas e engenheiros, que são responsáveis por ver o estado da arte da IA e dar conselhos à liderança.

Outra estrutura é o Departamento de AI responsável (ORA), que olha onde a Microsoft pode apoiar os reguladores para implementar regras dentro da empresa para que os princípios de IA responsável sejam considerados em tudo que é feito. Por último, há ainda um grupo de engenheiros que estão na ponta e são responsáveis por desenvolver ferramentas que apoiem os princípios de IA responsável da companhia.

“Fazemos uma análise de IA baseada em risco, que começa em consultores regionais e, a depender, chega até a nossa liderança. A gente acredita que tem as etapas, todo o arcabouço para definir qual caso vai ser levado até a liderança, mas se tratando de dados sensíveis, a decisão final deve ser sempre da liderança”, defende a executiva.

Na Microsoft hoje o curso de IA responsável é obrigatório para todos os funcionários, a ideia é entender e internalizar de fato os princípios de IA responsável na companhia.

“Na nossa visão, no final, o papel fundamentou de um Comitê de Ética é passar confiança e conseguir fazer com que a tecnologia seja mais usada”, resume Loren.

Daniel Arbiz, diretor jurídico da Google, acrescenta que ao se tratar de uma discussão tão embrionária, é fundamental olhar para fora da empresa e procurar ter trocas e aprender. Ele ressalta, por exemplo, que a proximidade com a academia é fundamental.

“A governança tem que ser evolutiva para conseguir atingir o objetivo que é o equilibrio entre ser ousado e inovador e ser responsável. As coisas precisam caminhar juntas e para isso é fundamental a escuta atenta e a correção de rumo sempre que necessário”, afirma Daniel.

Segundo ele, os princípios de IA responsável da Google foram estruturados em 2018 e orientam as decisões tomadas na empresa. Daniel Arbiz explica que a Google está investindo no campo da explicabilidade e da transparência, mas também na correção de vieses para a diminuição de impactos sociais potencialmente negativos na utilização da IA.

“Nós anunciamos princípios proativos, de: buscar IA benéfica; evitar criar ou reproduzir vieses injustos; respeitar as pessoas; contribuir com foco na segurança e com testes controlados conforme o nível de risco, inclusive testes e auditorias externa; e defender padrões elevados de rigorosidade científica. Além disso, o Google declarou que não vai desenvolver IA em situações consideradas como linhas vermelhas do desenvolvimento: quando o foco do desenvolvimento ocasionar danos sociais; em soluções usadas em tecnologias bélicas; em soluções voltadas à vigilância; e em projetos que sejam contrários ao direito internacional e aos direitos humanos”, enumerou o executivo.

+Notícias

Publicação da dosimetria para sanções será divisor de águas na LGPD

Brasil participa de discussão sobre regulação de Big Techs em Paris